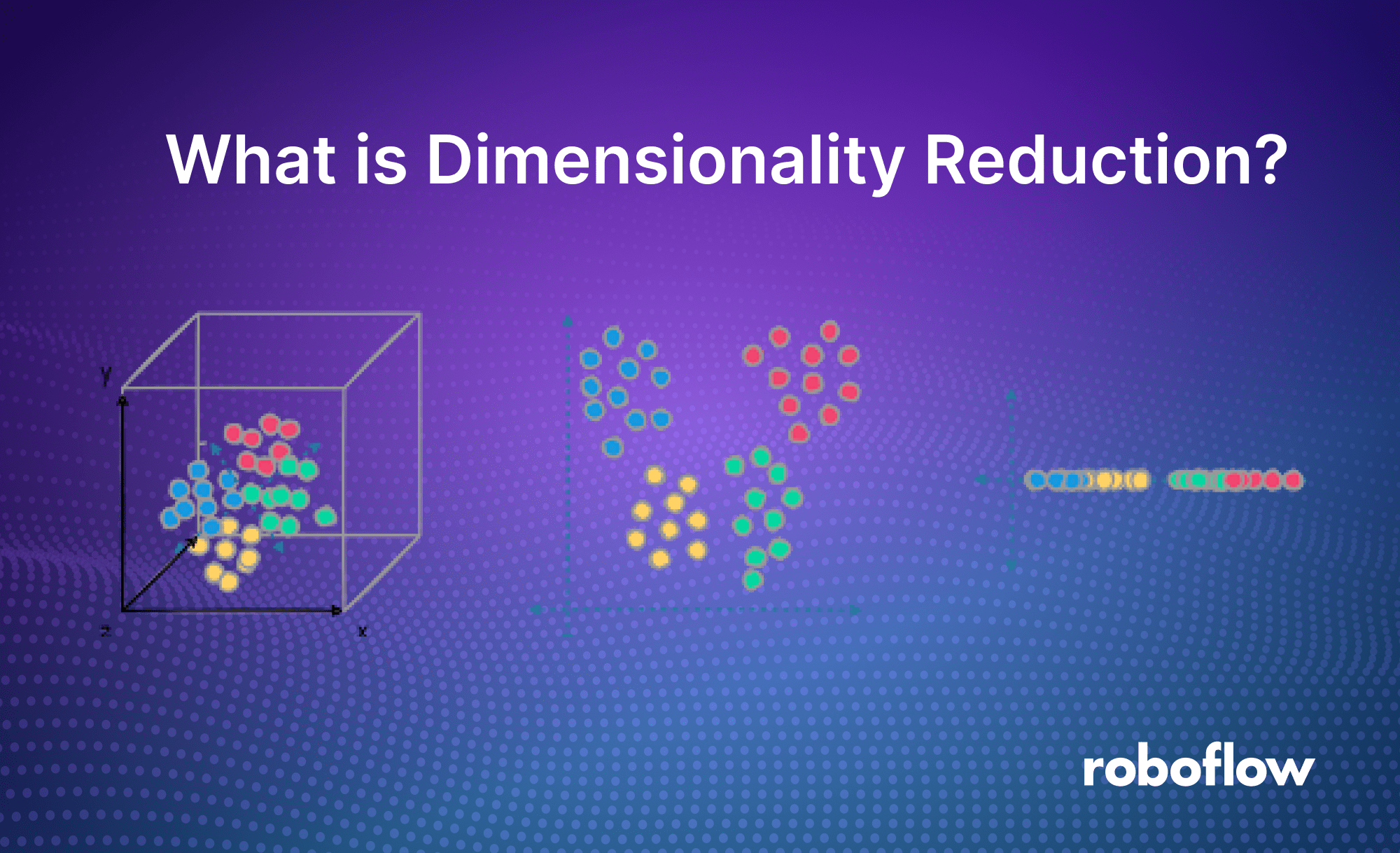

exploringdatascience.com – Dimensionality reduction, atau reduksi dimensi, adalah teknik penting dalam analisis data dan machine learning yang bertujuan menyederhanakan dataset besar dengan mengurangi jumlah fitur (variabel) tanpa kehilangan informasi penting. Di era big data 2025, di mana volume data global diperkirakan mencapai 181 zettabyte (Statista, 2025), teknik ini menjadi krusial untuk mengatasi kompleksitas data, meningkatkan efisiensi komputasi, dan mempermudah visualisasi. Di Indonesia, perusahaan seperti Gojek dan Tokopedia menggunakan reduksi dimensi untuk mengoptimalkan algoritma rekomendasi dan analisis pelanggan, menghemat hingga 30% waktu pemrosesan (Kominfo, 2025). Artikel ini menjelaskan konsep, metode utama, aplikasi, dan tips praktis untuk menerapkan dimensionality reduction dengan efektif.

Apa Itu Dimensionality Reduction?

Dimensionality reduction adalah proses mengubah dataset berdimensi tinggi (banyak fitur) menjadi representasi berdimensi rendah, sambil mempertahankan struktur atau informasi penting. Misalnya, dataset dengan 100 kolom (fitur) bisa direduksi menjadi 10 kolom tanpa mengorbankan akurasi model machine learning. Tujuannya adalah mengatasi “curse of dimensionality”—ketika dimensi tinggi menyebabkan model lambat, overfitting, atau sulit diinterpretasi.

Ada dua pendekatan utama:

- Feature Selection: Memilih subset fitur paling relevan (contoh: memilih hanya “usia” dan “pendapatan” dari 50 variabel demografis).

- Feature Extraction: Membuat fitur baru dari kombinasi fitur asli (contoh: Principal Component Analysis).

Manfaatnya meliputi:

- Efisiensi Komputasi: Mengurangi waktu pelatihan model hingga 50% (studi Google, 2024).

- Visualisasi: Memungkinkan plot 2D/3D dari data berdimensi tinggi.

- Kurangi Noise: Menghapus fitur tidak relevan, meningkatkan akurasi model hingga 10-15%.

Metode Utama Dimensionality Reduction

Berikut metode populer yang digunakan pada 2025, beserta kelebihan dan kekurangannya:

| Metode | Deskripsi | Kelebihan | Kekurangan |

|---|---|---|---|

| Principal Component Analysis (PCA) | Mengubah fitur menjadi komponen baru (principal components) yang menangkap varians maksimum. | Mudah diimplementasikan, efektif untuk data linier. | Sulit diinterpretasi, kurang cocok untuk data non-linier. |

| t-SNE (t-Distributed Stochastic Neighbor Embedding) | Mengurangi dimensi untuk visualisasi, fokus pada struktur lokal data. | Ideal untuk visualisasi 2D/3D. | Komputasi lambat, tidak cocok untuk data besar. |

| UMAP (Uniform Manifold Approximation and Projection) | Teknik modern untuk visualisasi dan clustering, lebih cepat dari t-SNE. | Cepat, menangkap struktur global dan lokal. | Membutuhkan tuning parameter. |

| Linear Discriminant Analysis (LDA) | Reduksi dimensi dengan memaksimalkan pemisahan antar kelas. | Cocok untuk klasifikasi terawasi. | Terbatas pada data dengan kelas jelas. |

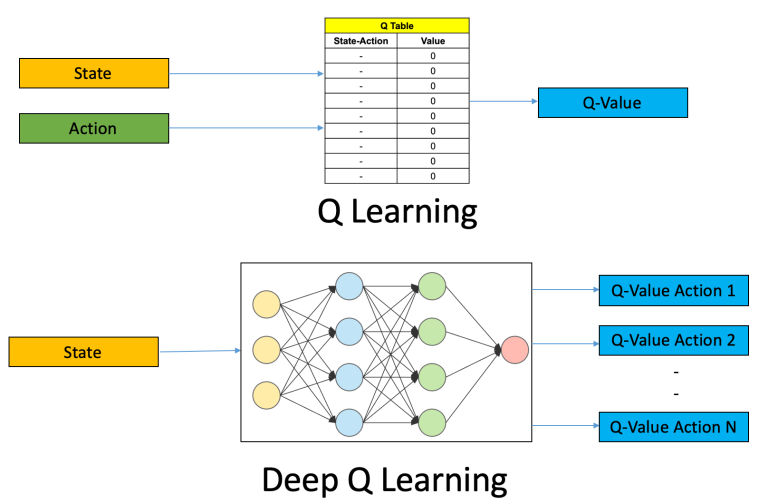

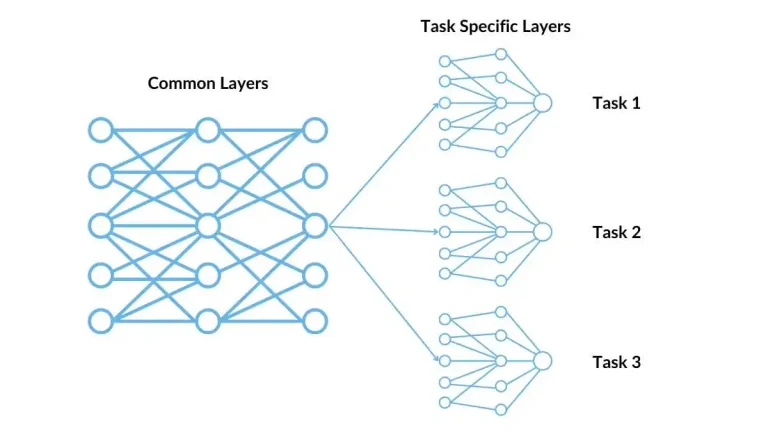

| Autoencoders (Neural Network) | Menggunakan jaringan saraf untuk kompresi data non-linier. | Fleksibel untuk data kompleks. | Membutuhkan data besar dan komputasi tinggi. |

Di Indonesia, PCA dan UMAP banyak digunakan di startup fintech seperti Akulaku untuk analisis kredit, sementara t-SNE populer di universitas untuk riset visualisasi data.

Aplikasi di Dunia Nyata

Dimensionality reduction digunakan luas di berbagai industri:

- E-commerce: Tokopedia gunakan PCA untuk menyederhanakan data pelanggan (usia, riwayat belanja) dalam sistem rekomendasi, meningkatkan konversi 20%.

- Kesehatan: Analisis gambar MRI direduksi dari ribuan piksel ke fitur utama untuk deteksi kanker, hemat waktu diagnosis hingga 40% (studi RSCM, 2025).

- Keuangan: Bank Mandiri gunakan LDA untuk memisahkan profil nasabah berisiko tinggi vs rendah, meningkatkan akurasi prediksi kredit.

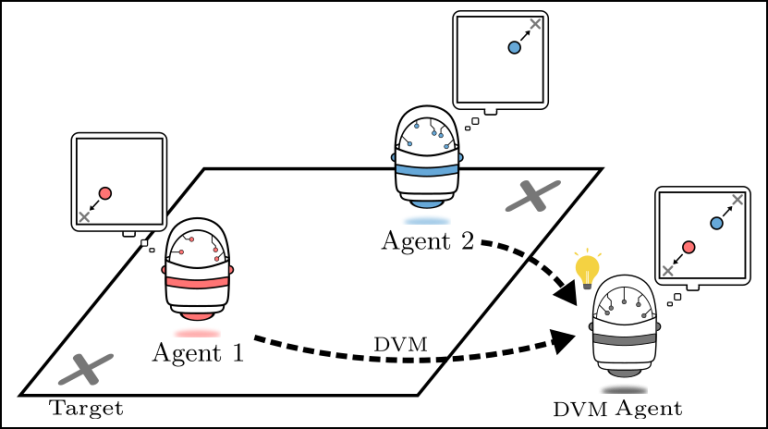

- Media Sosial: TikTok Indonesia gunakan UMAP untuk clustering konten video berdasarkan preferensi pengguna, meningkatkan engagement 15%.

- Penelitian: Universitas Indonesia gunakan t-SNE untuk visualisasi data genom, membantu identifikasi mutasi penyakit tropis.

Implementasi dengan Kode Python

Berikut contoh sederhana implementasi PCA menggunakan Python, populer di kalangan data scientist Indonesia:

Kode ini mengurangi fitur ke dua komponen utama, menjelaskan hingga 80-90% varians data, dan cocok dijalankan di laptop dengan RAM 8GB (biaya Rp 5-10 juta).

Tips Praktis untuk Pemula

- Pilih Metode Sesuai Tujuan: Gunakan PCA untuk efisiensi model, t-SNE/UMAP untuk visualisasi, atau Autoencoders untuk data kompleks.

- Standarisasi Data: Selalu lakukan scaling (contoh: StandardScaler) sebelum PCA untuk hasil akurat.

- Gunakan Library Gratis: Manfaatkan Scikit-learn atau UMAP-learn (open-source) di Python, tersedia gratis di Anaconda.

- Eksperimen Komponen: Coba jumlah komponen berbeda (misalnya, 2-10) untuk temukan keseimbangan akurasi dan efisiensi.

- Ikuti Komunitas: Bergabung dengan grup seperti Data Science Indonesia (10.000+ anggota di LinkedIn) untuk tutorial dan dataset lokal.

- Hemat Komputasi: Gunakan Google Colab (gratis) untuk dataset besar, hemat biaya server Rp 1-2 juta/bulan.

Tren di 2025

- AI-Enhanced Reduction: Algoritma seperti Autoencoders kini terintegrasi dengan GPT-4 untuk otomatisasi reduksi fitur.

- Cloud Integration: AWS dan Google Cloud tawarkan tool reduksi dimensi (contoh: SageMaker), digunakan oleh startup Indonesia.

- Edukasi: Kursus online di Coursera atau Dicoding (Rp 300.000) ajarkan PCA dan UMAP untuk pelajar Indonesia.

Dimensionality reduction adalah kunci untuk menyederhanakan data kompleks di era big data, meningkatkan efisiensi dan akurasi analisis. Dari PCA hingga UMAP, teknik ini digunakan luas di Indonesia untuk e-commerce, kesehatan, dan riset. Dengan Python dan library gratis, siapa pun bisa mulai menerapkannya—unduh Anaconda, coba kode PCA di atas, dan ubah data besar menjadi wawasan berharga. Pada 2025, jadilah bagian dari revolusi data—sederhanakan, analisis, dan menang!