exploringdatascience.com – Long Short-Term Memory (LSTM) adalah jenis arsitektur jaringan saraf tiruan (neural network) yang dirancang khusus untuk memproses dan memodelkan data berurutan, seperti teks, suara, atau deret waktu. Diperkenalkan pada tahun 1997 oleh Sepp Hochreiter dan Jürgen Schmidhuber, LSTM menjadi terobosan penting dalam bidang pembelajaran mesin (machine learning) karena kemampuannya untuk mengatasi masalah ketergantungan jangka panjang yang sering ditemui pada jaringan saraf berulang (recurrent neural networks/RNN) tradisional.

Apa Itu LSTM?

LSTM adalah varian dari RNN yang dirancang untuk mempelajari dan mengingat informasi dalam jangka waktu yang panjang. Tidak seperti RNN standar yang kesulitan menangani ketergantungan jarak jauh karena masalah vanishing gradient (gradien yang semakin kecil selama pelatihan), LSTM menggunakan mekanisme khusus yang disebut “gerbang” (gates) untuk mengatur aliran informasi. Mekanisme ini memungkinkan LSTM untuk secara selektif mengingat atau melupakan informasi yang relevan, menjadikannya sangat efektif untuk tugas-tugas seperti pemrosesan bahasa alami (NLP), prediksi deret waktu, dan pengenalan suara.

Cara Kerja LSTM

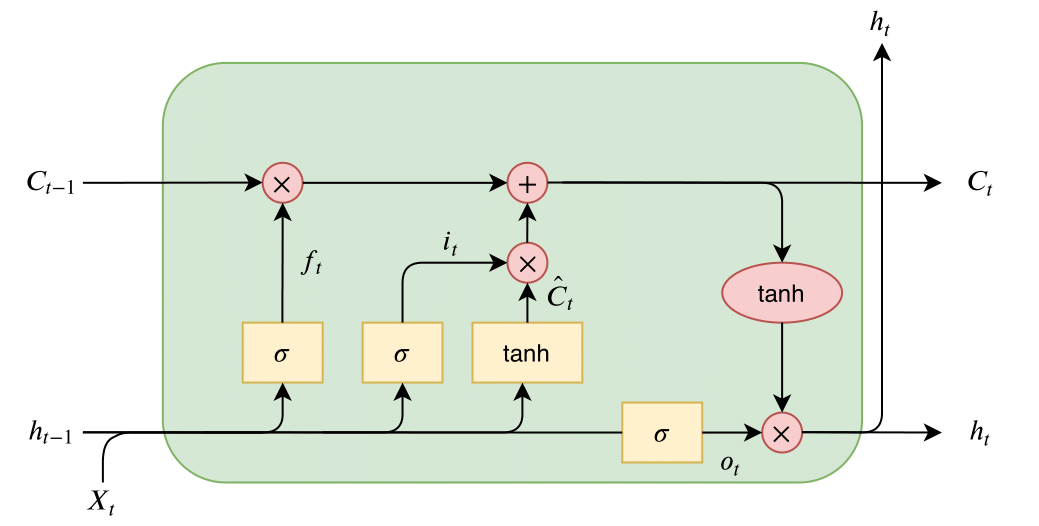

LSTM bekerja dengan memanfaatkan unit-unit memori yang disebut cell state dan tiga jenis gerbang utama: forget gate, input gate, dan output gate. Berikut penjelasan singkat tentang komponen-komponen ini:

-

Cell State: Bertindak sebagai “memori jangka panjang” yang menyimpan informasi penting dari data sebelumnya. Cell state memungkinkan informasi untuk mengalir melalui urutan tanpa kehilangan konteks.

-

Forget Gate: Memutuskan informasi mana yang akan dibuang dari cell state. Gerbang ini menggunakan fungsi sigmoid untuk menghasilkan nilai antara 0 (lupakan sepenuhnya) dan 1 (simpan sepenuhnya).

-

Input Gate: Menentukan informasi baru yang akan ditambahkan ke cell state. Gerbang ini bekerja bersama dengan candidate cell state untuk memperbarui memori dengan data baru yang relevan.

-

Output Gate: Mengontrol informasi yang akan dikeluarkan dari sel LSTM pada setiap langkah waktu, yang kemudian digunakan untuk prediksi atau diproses lebih lanjut.

Dengan kombinasi gerbang ini, LSTM dapat secara efektif menangani data berurutan dengan menjaga keseimbangan antara memori jangka pendek dan jangka panjang, sehingga cocok untuk tugas yang memerlukan pemahaman konteks yang kompleks.

Penerapan LSTM

LSTM telah digunakan secara luas di berbagai bidang karena fleksibilitas dan keefektifannya. Beberapa penerapan utama meliputi:

-

Pemrosesan Bahasa Alami (NLP):

-

Penerjemahan Mesin: LSTM digunakan dalam model seperti Google Translate untuk menerjemahkan teks dengan memahami konteks kalimat.

-

Analisis Sentimen: Memproses ulasan atau posting media sosial untuk menentukan emosi atau opini.

-

Generasi Teks: Membuat teks yang koheren, seperti dalam chatbot atau penulisan otomatis.

-

-

Prediksi Deret Waktu:

-

Digunakan untuk meramalkan harga saham, cuaca, atau konsumsi energi berdasarkan data historis.

-

-

Pengenalan Suara dan Audio:

-

LSTM membantu sistem seperti asisten suara (misalnya, Siri atau Google Assistant) untuk memahami perintah lisan dengan menangkap pola temporal dalam sinyal audio.

-

-

Analisis Video:

-

Digunakan untuk memproses urutan frame video, seperti dalam pengenalan aktivitas atau deteksi anomali.

-

Keunggulan LSTM

-

Menangani Ketergantungan Jangka Panjang: LSTM sangat baik dalam mempelajari hubungan antar data yang terpisah jauh dalam urutan, seperti dalam teks panjang atau deret waktu.

-

Fleksibilitas: Dapat digunakan untuk berbagai jenis data berurutan, mulai dari teks hingga sinyal audio.

-

Kinerja Tinggi: LSTM sering kali menghasilkan hasil yang lebih baik dibandingkan RNN tradisional dalam tugas-tugas kompleks.

Tantangan dan Keterbatasan

Meskipun powerful, LSTM juga memiliki beberapa tantangan:

-

Kompleksitas Komputasi: LSTM membutuhkan daya komputasi yang lebih besar dibandingkan model lain, terutama untuk dataset besar.

-

Waktu Pelatihan: Proses pelatihan LSTM bisa memakan waktu lama karena struktur gerbangnya yang kompleks.

-

Alternatif Modern: Model seperti Transformer (misalnya, BERT atau GPT) mulai menggantikan LSTM dalam beberapa aplikasi NLP karena efisiensi dan skalabilitasnya yang lebih baik.

Perkembangan dan Masa Depan LSTM

Meskipun Transformer kini mendominasi banyak aplikasi NLP, LSTM tetap relevan untuk tugas-tugas tertentu, terutama yang melibatkan data berurutan dengan sumber daya komputasi terbatas atau kebutuhan model ringan. Penelitian terus dilakukan untuk meningkatkan efisiensi LSTM, seperti dengan mengintegrasikannya ke dalam arsitektur hybrid atau mengurangi kompleksitas komputasinya.

Selain itu, varian LSTM seperti Gated Recurrent Unit (GRU), yang lebih sederhana namun tetap efektif, juga digunakan sebagai alternatif untuk menyeimbangkan kinerja dan efisiensi. Di masa depan, LSTM kemungkinan akan terus berperan dalam aplikasi spesifik seperti perangkat IoT atau sistem tertanam yang memerlukan pemrosesan data berurutan secara real-time.

Long Short-Term Memory (LSTM) adalah terobosan penting dalam dunia pembelajaran mesin yang memungkinkan komputer untuk memahami dan memproses data berurutan dengan lebih baik. Dengan mekanisme gerbangnya yang cerdas, LSTM mampu menangani ketergantungan jangka panjang, menjadikannya alat yang sangat berharga dalam berbagai aplikasi, mulai dari NLP hingga prediksi deret waktu. Meskipun menghadapi persaingan dari model yang lebih baru seperti Transformer, LSTM tetap menjadi pilar penting dalam pengembangan teknologi AI, membuktikan bahwa desainnya yang tangguh dan fleksibel masih relevan di era modern.